梯度提升决策树+逻辑回归

GBDT模型

GBDT模型是一个集成模型,基本类器采用CART,集成方法为Gradient Boosting。

Gradient Boosting

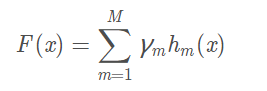

GBDT和Adaboost模型一样,都可以表示成

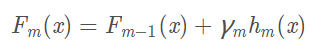

GBDT虽然是一个加性模型,但是其是通过不断迭代拟合样本真实值与当前分类器的残差来逼近真实值的,按照这个思路,第m个基分类器的预测结果为:

而hm(x)的优化目标就是最小化当前预测结果Fm-1(xi)+h(xi)和yi之间的差距。

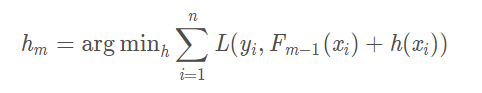

下面是GBDT的一个简单例子:判断用户是否会喜欢电脑游戏,特征有年龄,性别和职业。

需要注意的是,GBDT无论是用于分类和回归,采用的都是回归树,分类问题最终是将拟合值换为概率来进行分类的。

GBDT进行特征转换的过程

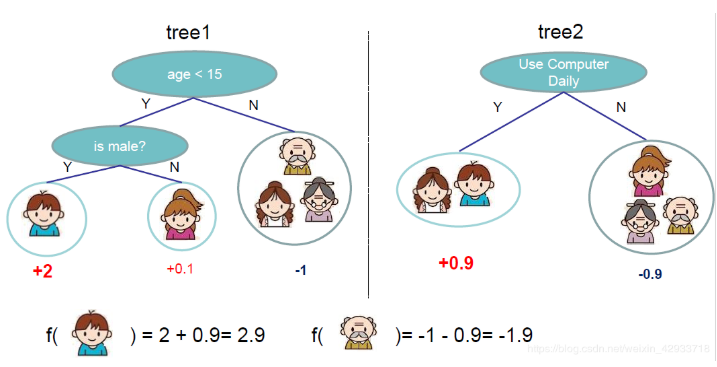

利用训练集训练好GBDT模型之后,就可以利用该模型完成从原始特征向量到新的离散型特征向量的转化。具体过程如下。

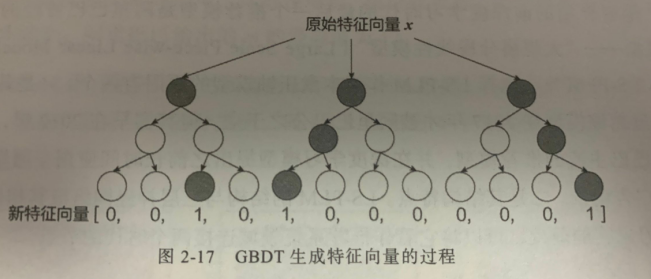

一个训练样本在输入GBDT的某一子树后,会根据每个节点的规则最终落入某一叶子节点,把该叶子节点置为1,其它叶子节点置为0,所有叶子节点组成的向量即形成了该棵树的特征向量,把GBDT所有子树的特征向量连接起来,即形成了后续LR模型输入的离散型特征向量。

举例来说,如下图所示,GBDT由三棵树构成,每棵子树有四个叶子节点,输入一个样本后,其先后落入“子树1”的第三个叶子节点中,那么特征向量就是[0,0,1,0],”子树2”的第一个叶节点,特征向量为[0,0,0,1],”子树3”的第四个叶节点,特征向量为[0,0,0,1],最后连接所有特征向量,所形成最终的特征向量[0,0,1,0,1,0,0,0,0,0,0,1]。

GBDT的优点

决策树的深度决定了特征交叉的阶数。如果决策树的深度为4,则通过了3次节点分裂,最终的叶子节点实际上是进行三阶特征组合后的结果,如此强的特征组合能力显然是FM系模型所不具备的。

GBDT的缺点

GBDT容易产生过拟合,以及GBDT的特征转换方式实际上丢失了大量特征的数值信息,因此不能简单地说GBDT的特征交叉能力强,效果就比FFM好,在模型的选择和调试上,永远都是多种因素综合作用的结果。

GBDT+LR组合模型开启的特征工程新趋势

GBDT+LR组合模型对于推荐系统领域的重要性在于,它大大推进了特征工程模型化这一重要趋势。在GBDT+LR组合模型出现之前,特征工程的主要解决方法有两个:

- 进行人工的或半人工的特征组合和特征筛选

- 通过改造目标函数,改进模型结构,增加特征交叉项的方式增强特征组合能力

第一种方法对算法工程师的经验和精力投入要求较高,第二种方法则要求从根本上改变模型结构,对模型的设计能力要求较高。

GBDT+LR组合模型的提出,意味着特征工程可以完全交由一个独立的模型来完成,模型的输入可以是原始的特征向量,不必在特征工程上投入过多的人工筛选和模型设计的精力,实现真正的端到端训练。